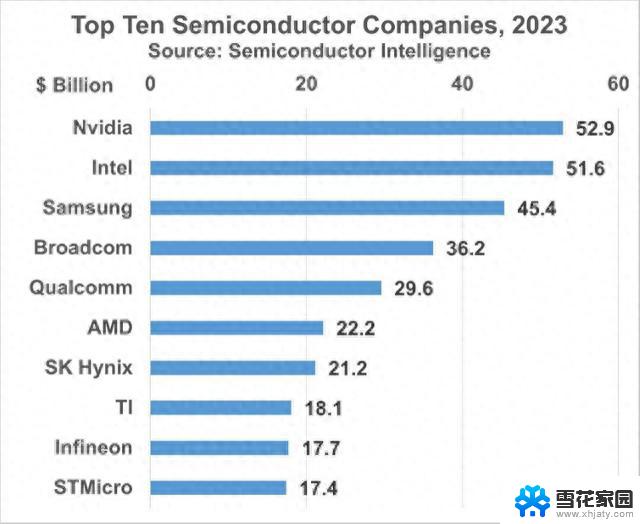

业内人士称AMD明年将出货多达40万个AI GPU MI300,行业领先的人工智能图形处理器供应商

业内人士透露,AMD新一代人工智能(AI)GPU系列Instinct MI300即将上市,预计2024年出货量将达到30万-40万个。

AMD计划于2023年12月6日在直播活动中发布Instinct MI300数据中心GPU加速器。该公司表示,这将凸显其与AI硬件和软件合作伙伴的增长势头。

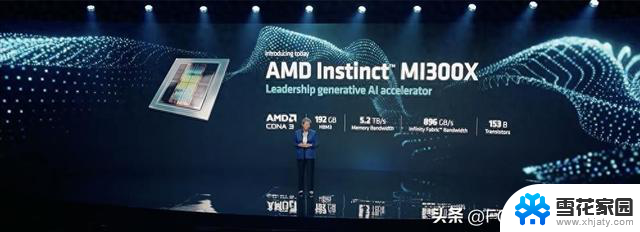

AMD董事长兼CEO苏姿丰将与公司高管、AI生态系统合作伙伴和客户一起讨论AMD产品和软件如何重塑AI、自适应和高性能计算(HPC)格局。

Instinct MI300被认为是唯一能够挑战英伟达在AI GPU领域主导地位的产品。AMD最大客户微软预计也将在活动上展示对Instinct MI300新产品的支持。

尽管美国收紧对中国半导体芯片和设备出口的禁令,但业内人士指出,AI GPU的需求一直在增长。消息人士称,AMD MI300系列的出货量预计在2024年将达到30万-40万个,微软和谷歌是AMD新款AI GPU加速器的大客户。

消息人士称,如果不是台积电CoWoS封装产能短缺,而且英伟达已经预留台积电40%的CoWoS产能,AMD可能会设定更高的出货目标。

在11月中旬的微软活动中,AMD和微软已经展示了AMD产品(包括即将推出的AMD Instinct MI300X加速器、AMD EPYC CPU和带有AI引擎的AMD Ryzen CPU)如何在云和生成式AI、机密计算、云计算以及更智能个人电脑(PC)中实现新的服务和计算能力。

AMD透露,MI300X基于下一代AMD CDNA 3加速器架构,支持高达192GB的HBM3内存,为生成式AI工作负载提供大语言模型训练和推理所需的计算和内存效率。该公司表示,凭借AMD Instinct MI300X的大内存,客户可以在单个MI300X加速器上安装大语言模型,例如Falcon-40(一种400亿参数模型)。

AMD还开发了用于数据中心加速器的ROCm软件生态系统,该公司已准备好与行业领导者合作,整合开放的AI软件生态系统。

微软透露,已经创建具有1.5TB HBM(高带宽内存)的虚拟机(VM),该虚拟机利用了AMD旗舰MI300X GPU的强大功能。微软表示,搭载 MI300X GPU的Azure VM为客户提供了更多针对AI优化的VM的选择。

AMD表示,其第四代EPYC处理器现已用于运行微软新一代通用、内存密集型和计算优化的虚拟机。

业内人士指出,AMD MI300系列采用台积电的先进封装服务,主要支持CoWoS的SoIC堆叠技术,而AMD目前是台积电专有SoIC服务的最大客户。消息人士补充称,苹果和英伟达预计将在2025年之后采用该技术。

消息人士称,台积电正在加速龙潭和台中工厂的CoWoS产能扩张,竹南AP6工厂为CoWoS封装提供支持。消息人士称,对于CoWoS,台积电还将oS工艺外包给OSAT,但利润率较低。随着AI芯片需求飙升,台积电一直在扩大CoWoS产能,预计到2024年底每月产能将达到3万片以上。

AMD指出,已经获得许多客户的MI300系列订单,并将第四季度AI GPU销售额预期从之前的3亿美元上调至4亿美元。AMD预计2024年其AI GPU销售额将超过20亿美元。

业内人士透露,预计从2024年第一季度开始,AI芯片供应链销售将有所改善。