NVIDIA公布最新MLPerf成绩,成绩依然稳坐第一,巩固AI领域领先地位

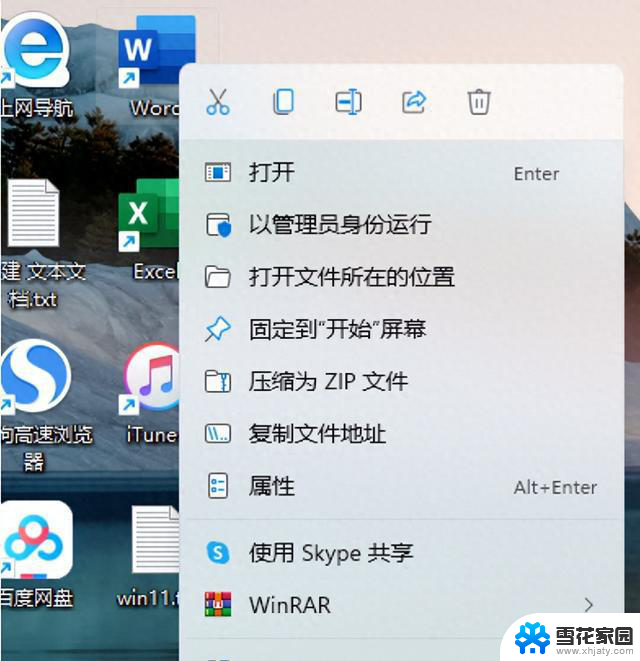

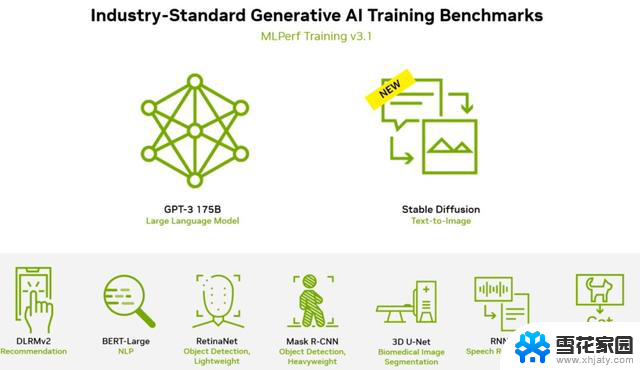

MLPerf AI性能的测试基准在3.1更新版中加入Stable Diffusion训练测试,而NVIDIA也在最新公布的结果取得好成绩。

MLPerf是产业用于衡量AI性能的测试基准,包括Amazon、Arm、Baidu、Google、Intel、Meta、Microsoft。以及哈佛大学、斯坦福大学、多伦多大学在内的众多企业与学术单位皆支持这项标准。

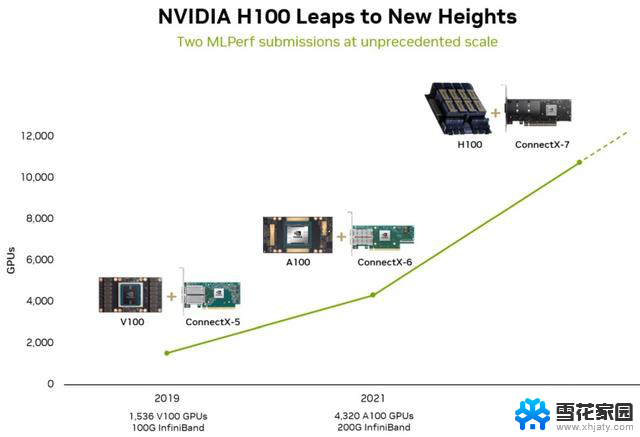

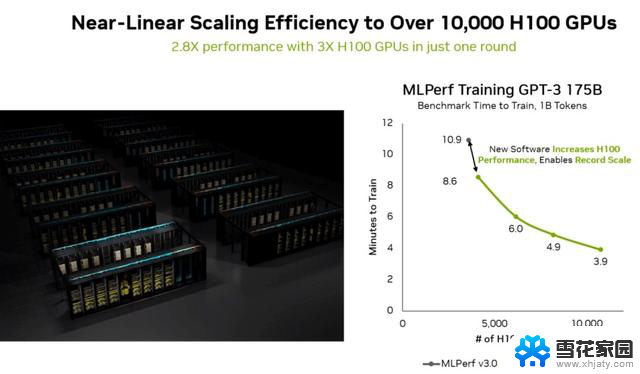

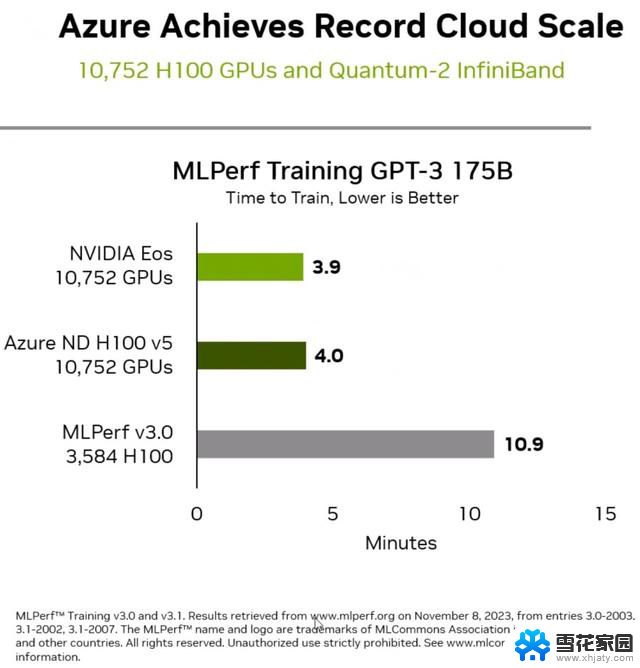

这次发布的最大亮点在于使用由10,752组H100 GPU搭配Quantum-2 InfiniBand网络互联技术的NVIDIA Eos人工智能超级计算机,它在短短3.9分钟完成拥有1,750组个参数的GPT-3模型训练,与NVIDIA在不到6个月前始推出时仅使用3,584组H100 GPU的10.9分钟记录相比提升约2.8倍。至于其他成绩资讯与图表则整理于下。

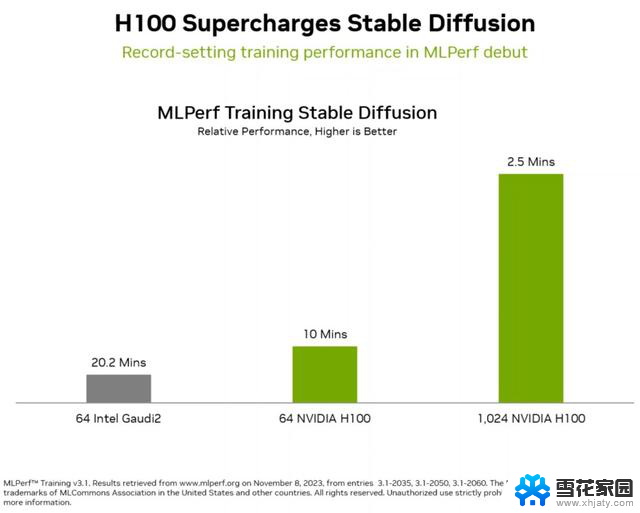

MLPerf在3.1更新版中加入Stable Diffusion文本对图像生成模型的训练测试。

目前NVIDIA已可组成共有10,752组H100 GPU的超大型运算集群。

NVIDIA Eos人工智能超级计算机由10,752组H100 GPU,AI算力高达42.6EFLOPS。

NVIDIA再次成为唯一完成所有MLPerf测试的公司,也创下6项新纪录。

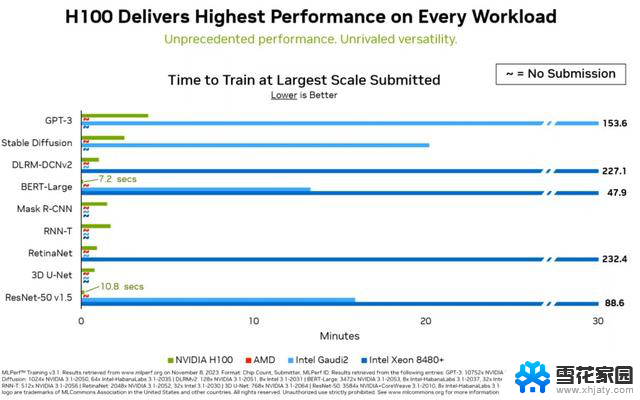

在多项AI训练测试中,H100都展现压倒性领先。(图中的-符号代表未提交成绩)

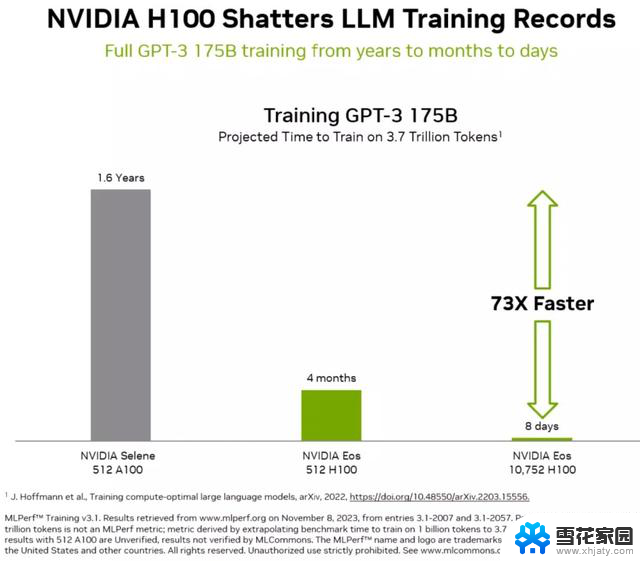

受益于新款GPU带来的Scale-Up与更多GPU组成集群带来的Scale-Out效益,让GPT-3 175B模型的训练时间度量从年缩短到月,再缩短到日。

运算集群的H100 GPU数量由3,584组扩展至3倍的10,752组,而性能提升约2.8倍,换算之下Scale-Out的效率高达93%。

由10,752组H100 GPU组成的Microsoft Azure云计算服务器性能表现与Eos人工智能超级计算机性能相差不到2%,展现在数据中心和公有云部署的高效率。

在同样使用64组GPU/加速器的条件下,H100的Stable Diffusion训练测试速度大约为Intel Gaudi 2的2倍。

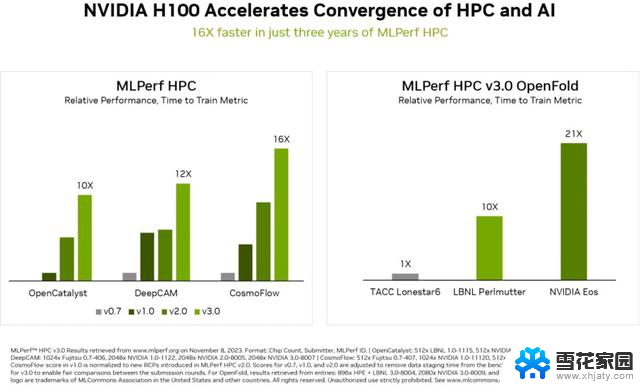

NVIDIA的MLPerf HPC(高性能计算)测试成绩较最初有10-16倍不等的表现(笔者注:使用的软硬件并不相同),而在新加入的OpenFold氨基酸串行预测蛋白质3D结构模型测试中也有长足进步。

由于多数药物皆作用于蛋白质,因此OpenFold是协助科学家了解蛋白质的结构,并快速研发有效药物的关键。在最新测试中,H100 GPU在7.5分钟内完成OpenFold模型训练相较于2年前AlphaFold训练使用128个加速器并耗时11天,能够明显提升工作效率。